Для неравенства типа > ограничение на невязку /-го условия можно записать следующим образом [c.65]

В указанных условиях невязка 5 (х) является также нормально распределенной величиной с математическим ожиданием [c.65]

Здесь , = -Ф- (т,-) <оуЦ Г= Г-Ф- (т,-) (а(>) В случае вероятностных ограничений типа < невязка г -го условия [c.67]

Невязка /-го условия задачи t-ro этапа [c.82]

Рассмотрим один из возможных алгоритмов решения, основывающийся на идее применения метода штрафных функций. В качестве нелинейных штрафных членов следует взять невязки за счет невыполнения последних ограничений (5). Тогда новая целевая функция запишется в виде [c.62]

Очевидно, что для всех отрицательных невязок следует выбрать такое положительное значение zt, при котором соответствующее значение ф обращается в нуль. Вспомогательное неизвестное zt для положительных невязок необходимо принять-равным нулю. Будем нумеровать нулевые невязки индексом /, а положительные t" (соответственно Z >0, zt" = Q). [c.63]

Переменные 2 -I) выбираются следующим образом. Значения Zr l), очевидно, должны быть равны нулю.. Ввиду того, что в состав линейной формы не входят переменные грезультате получим полный набор переменных, определяющих положение вектора R, (LF = VF (R0)fi). [c.64]

Таким образом, вклад в общую ошибку каждого веса вычисляется локально, простым умножением невязки нейрона <5>.[п] на значение соответствующего входа. (Из-за этого, в случае [c.59]

В случае со входными переменными дело обстоит по-другому обучение весов нижнего слоя сети определяется непосредственно значениями входов на них умножаются невязки, зависящие от выходов. Между тем, если с точки зрения операции умножения значения 1 равноправны, между 0 и 1 имеется существенная асимметрия нулевые значения не дают никакого вклада в градиент ошибки. Таким образом, выбор схемы кодирования входов влияет на процесс обучения. В силу логической равноправности обоих значений входов, более предпочтительной выглядит симметричная кодировка — 1, 1 , сохраняющая это равноправие в процессе обучения. [c.130]

Целью процедуры минимизации является отыскание глобального минимума — достижение его называется сходимостью процесса обучения. Поскольку невязка зависит от весов нелинейно, получить решение в аналитической форме невозможно, и поиск глобального минимума осуществляется посредством итерационного процесса — так называемого обучающего алгоритма, который исследует поверхность невязки и стремится обнаружить на ней точку глобального минимума. Иногда такой алгоритм сравнивают с кенгуру, который хочет попасть на вершину Эвереста, прыгая случайным образом в разные стороны. Разработано уже более сотни разных обучающих алгоритмов, отличающихся друг от друга стратегией оптимизации и критерием ошибок. [c.26]

Коль скоро обучение основывается на минимизации значения некоторой функции (показывающей, насколько результат, который выдает сеть на данном обучающем множестве, далек от образцового значения), нужно, прежде всего, выбрать меру ошибки, соответствующую сути задачи. Удачный выбор меры погрешности обычно приводит к более гладкой поверхности невязки и упрощает задачу обучения (см. [269]). Обычно в качестве меры погрешности берется средняя квадратичная ошибка (MSE), которая определяется как сумма квадратов разностей между желаемой величиной выхода dk и реально полученными на сети значениями yk для каждого примера f [c.27]

Перед тем, как начинать процесс обучения нейронной сети, необходимо присвоить весам начальные значения. Цель здесь, очевидно, должна состоять в том, чтобы найти как можно более хорошее начальное приближение к решению и таким образом сэкономить время обучения и улучшить сходимость. Конечно, можно положить начальные веса во всей сети равными нулю, но тогда частные производные от невязки по всем весам будут одинаковыми, и изменения весов не будут должным образом структурированы. В результате нельзя будет надеяться на то, что сеть вообще когда-нибудь сможет решить задачу. Нужно искать способы уйти от такой симметрии. [c.29]

Как уже говорилось, поверхность невязки в пространстве весов в общем случае имеет локальные минимумы, и это является главным препятствием для процесса обучения нейронной сети, в особенности, для алгоритма спуска. Можно встретить утверждения, что в ряде случаев локальный минимум является вполне приемлемым решением [105], однако в общей ситуации необходимо разработать стратегию, которая позволяла бы избегать таких точек и гарантировала бы сходимость обучающего алгоритма к глобальному решению. [c.30]

Для того чтобы обучающий алгоритм не стал двигаться в ложном направлении, нужно, прежде всего, упорядочить случайным образом последовательность примеров, которые он обрабатывает (так называемое взбалтывание ). Это не так существенно для эпохального варианта ВР, но очень важно при стохастическом определении весов. Всякая программная реализация алгоритма типа ВР должна >хлю-чать в себя случайное упорядочение обучающего множества. Более того, если какой-то из классов примеров представлен недостаточно, I случайный выбор должен осуществляться таким образом, чтобы примеры из слабо представленной группы встречались чаще — этим будет устранен ложный крен при минимизации невязки. В гл. 8 читатель найдет иллюстрирующий пример. [c.30]

Ранее уже было сказано, что выбор величины шага имеет ключевое значение для успешной работы обучающего алгоритма. При слишком маленьком шаге обучение будет медленным и велика будет вероятность попадания в локальный минимум на поверхности невязки. Наоборот, при слишком большом шаге можно проскочить мимо глобального минимума. То, какой шаг следует считать малым, [c.31]

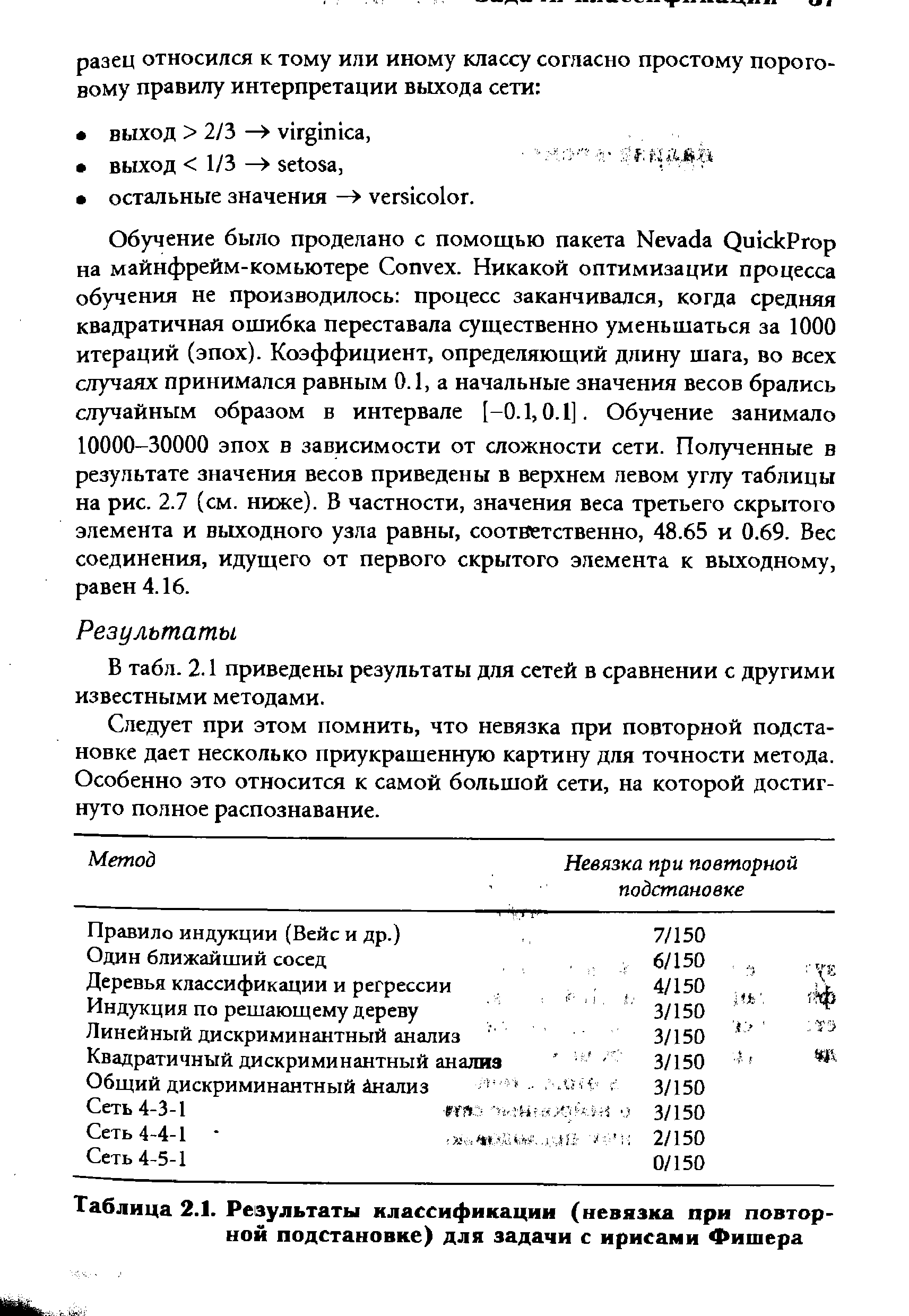

Следует при этом помнить, что невязка при повторной подстановке дает несколько приукрашенную картину для точности метода. Особенно это относится к самой большой сети, на которой достигнуто полное распознавание. [c.55]

Метод Невязка при повторной [c.55]

| Таблица 2.1. Результаты классификации (невязка при повторной подстановке) для задачи с ирисами Фишера |  |

Подгонка моделей связана с такой корректировкой значений параметров Ри начальных условий переменных Xt(i =1, ri), которая приближала бы модель к описываемой ею реальной системе при сохранении выбранной структуры и базовых уравнений. Например, пусть у реальной системы измеряется конкретная характеристика Yn раз в определенные моменты времени tv ty. .., tn и соответственно фиксируются значения у, у2,. .., уп. При тех же условиях по модели фиксируем состояния Y , Yy...,Yn, где Yi — прогнозируемые величины характеристик системы. Если имеется разница между значениями у. и Yp то ее величина называется невязкой и обозначается как [c.17]

Если линейное соотношение, действительно, справедливо и эмпирические данные (ti, yO, (t2, у2),. .., (t.,, у ) измерены точно, то полученная система совместна, ранг матрицы системы равен двум (число неизвестных) и значения коэффициентов линейной зависимости можно найти из первых двух уравнений системы. На практике такая ситуация невозможна — эмпирические данные по своей природе всегда содержат ошибку, а линейная модель лишь приближенно описывает реальные связи величин. Следовательно, система несовместна и ее нормальное обобщенное решение позволяет найти наилучшие приближенные значения коэффициентов линейной функции, поскольку в этом случае невязка минимальна. Построенному таким образом решению можно дать геометрическую [c.87]

Пусть в задаче А А(У) —> max /у E DA для каждого j-ro из условий, определяющих множество DA, может быть введена норма AJ отклонения этого условия от его номинального значения (норма невязки). [c.323]

Отрицательная величина s означает, что оценки экспертов (упорядочивание D > С > А > В противоречивы. Тем не менее, получены значения весов критериев при которых эти противоречия сведены к минимуму, т.е. система неравенств не имеет решения, но найдено решение с минимальной невязкой. В этом случае имеем следующие оценки вариантов. [c.109]

Заметим, что в задачах стохастического программирования со статистическими условиями связка в ограничениях исключена не во всех случаях, как IB жестких постановках, и не в большинстве случаев, как в задачах с вероятностными ограничениями (при j>V2), а в среднем. Это значит, что невязки могут возникнуть при каждой реализации условий. Однако невязки условий, отвечающие различным реализациям состояния природы, компенсируют друг друга так, что средняя невязка условий равна нулю. [c.10]

Первая группа параметров определяет предварительное решение об объеме продуктов, производимых по тому или иному технологическому способу. Информация об этих параметрах позволяет руководству предприятия подготовить оснастку производства, заключить договоры с соисполнителями, провести всю необходимую организационную и технологическую подготовку и начать выпуск продукции. После установления спроса (после наблюдения реализации случайных параметров условий задачи) вычисляется вторая группа параметров решения — коррекции плана. Коррекция вызывается необходимостью компенсации невязок — несоответствия между спросом и объемом продукции, определяемым предварительным планом. Компенсация невязок производится посредством заранее установленного набора технологических способов. Каждой реализации спроса соответствует свой план компенсации невязок. Естественно полагать, что компенсация невязки связана с большими затратами, чем производство того же объема продукции в соответствии с предварительным планом. Поэтому разработка предварительного плана должна учитывать всю априорную информацию о статистических характеристиках спроса, чтобы свести к минимуму суммарные затраты на производство требуемой продукции. Выбор оптимального плана в задачах подобного рода определяется тем, как будут оценены невязки в условиях задачи и каким образом оценка невязки сопоставляется с затратами на реализацию предварительного плана. Разработка предварительного плана и компенсация невязок — два этапа решения одной задачи. В соответствии с этим задачи рассматриваемого типа называют двухэтапными задачами стохастического программирования. Трудности, с которыми связан анализ двухэтапных задач, в значительной степени определяются необходимостью такого выбора предварительного плана разрешимой задачи, который гарантировал бы существование компенсации невязок при всех реализациях случая. Двухэтапные задачи, структура условий которых обладает тем свойством, что при любом плане первого этапа компенсация невязок всегда оказывается возможной, существенно проще в исследовании. Двухэтапным задачам посвящена богатая литература и для целого ряда частных постановок имеются вполне приемлемые методы построения решения. [c.13]

В многоэтапных задачах упомянутого типа предполагается, что на каждом последующем этапе требуется полностью компенсировать невязки, связанные с принятыми решениями и реализованными значениями параметров условий. Перспективным обобщением многоэтапных задач с жесткими условиями являются многоэтапные задачи стохастического программирования с безусловными и условными вероятностными или статистическими ограничениями. <В задачах этого класса требуется,, чтобы на каждом этапе вероятность удовлетворения ограничений превышала некоторую заранее заданную величину или чтобы математические ожидания некоторых функций от невязок условий были бы ограничены заданными числами или функциями от наблюденных на предыдущих этапах значений случайных параметров. Кроме того, на каждом этапе могут быть заданы и жесткие ограничения. [c.14]

Та же самая задача может быть решена с использованием однослойной сети с единственным входным и единственным линейным выходным нейроном. Вес связи а и порог Ъ могут быть получены путем минимизации той же величины невязки (которая в данном случае будет называться среднеквадратичной ошибкой) в ходе обучения сети, например методом ba kpropagation. Свойство нейронной сети к обобщению будет при этом использоваться для предсказания выходной величины по значению входа. [c.200]

Еще одним существенным различием является то. что для методов статистики не имеет значения, каким образам будет минимизироваться невязка - в любом случае модель остается той же самой, в то время как для нейрокомпьютинга главную роль играет именно метод обучения. Иными словам и. в отличие от нейросетевого подхода оценка параметров модели для статистических методов не зависит от метода минимизации. В то же время статистики будут рассматривать изменения вида невяэки скажем на [c.201]

На этапе обучения происходит вычисление синаптических коэффициентов в процессе решения нейронной сетью задач (классификации, предсказания временных рядов и др.), в которых нужный ответ определяется не по правилам, а с помощью примеров, сгруппированных в обучающие множества. Такое множество состоит из ряда примеров с указанным для каждого из них значением выходного параметра, которое было бы желательно получить. Действия, которые при этом происходят, можно назвать контролируемым обучением учитель подает на вход сети вектор исходных данных, а на выходной узел сообщает желаемое значение результата вычислений. Контролируемое обучение нейронной сети можно рассматривать как решение оптимизационной задачи. Ее целью является минимизация функции ошибок, или невязки, Е на данном множестве примеров путем выбора значений весов W. Суть задачи оптимизации станет яснее, если представить себе график невязки, рассматриваемой как функция весов (эта функция определена в многомерном пространстве весов, где каждому весовому коэффициенту соответствует своя размерность). Из-за нелинейностей функций активации полученная поверхность в общем случае будет очень сложной наряду с плоскими участками на ней будут локальные минимумы, седдовые точки, [c.25]

Риё. 1.4. Поверхность невязки для сети с одним узлом (1 вес и 1 порог) и сиг- > моидной функцией активации. Были взяты 3 примера со входами 0.6, 0.7, -0.3 и значениями выхода, соответственно, 0.5, 0.25 и 0.3 [c.26]

При более последовательном подходе для улучшения процесса обучения можно использовать информацию о производных второго порядка от функции невязки. Соответствующие методы оптимизации называются квадратичными. Вся указанная информация собрана в матрице гессиана Н, имеющей размеры Nw х Nw, где Nw — число весов. Эта матрица содержит информацию о том, как изменяется градиент при малых смещениях по различным направлениям в пространстве весов. Прямое вычисление матрицы требует большого времени, поэтому разработаны методы, позволяющие избежать вычисления и хранения матрицы (спуск по сопряженному градиенту, масштабированный метод сопряженных градиентов (см. [197]), RBa kProp (см. [212]), квази-ньютоновский метод, метод Левенбер-га-Маркара). [c.32]

Обучение нейронной сети обычно рассматривается как решение оптимизационной задачи минимизация функции ошибки или невязки на данном множестве примеров путем выбора значений весов ay. Разработано очень много обучающих алгоритмов, отличающихся друг от друга стратегией оптимизации и критерием ошибки (функцией). Выбор алгоритма обучения также зависит от знаний и опыта специалиста. Наиболее распространенным алгоритмом обучения нейронных сетей с прямой связью является алгоритм обратного распространения ошибки (Ba kpropagation - ВР). На этапе проверки достоверности работа сети сравнивается с данными контрольного множества. Желательно, чтобы они полностью отличались от применявшихся на предыдущем этапе. [c.279]

Во многих задачах управления в условиях неполной информации, свя занных с повторяющимися ситуациями, нет необходимости в том, чтобы ограничения задачи удовлетворялись при каждой реализации случая (или, как говорят, при каждой реализации состояния природы). Затраты на накопление информации или другие затраты, обеспечивающие исключение невязок в условиях задачи, могут превышать достигаемый при этом эффект. Часто конкретное содержание задачи требует лишь, чтобы вероятность попадания решения в допустимую область превышала некоторое заранее заданное число а>0. В тех случаях, когда возможные невязки в отдельных ограничениях вызьшают различный ущерб, целесообразно дифференцированно подходить к разным условиям. Чтобы уравновесить ущерб, определяемый невязками в разных условиях задачи, естественно ограничить снизу вероятность выполнения каждого из них различными числами а >0. Обычно аг>]/2- Подобные постановки задач стохастического программирования называются моделями с вероятностными ограничениями. Если коэффициенты линейной формы сх задачи детерминированы, то показатель 1 качества (1.1) является в то же время и целевой функцией задачи с вёроятност-ными ограничениями. Если компоненты вектора с случайны , TQ в качестве целевой функции задачи с вероятностными ограничениями обычно выбирают математическое ожидание линейной формы (1.1) или вероятность превышения линейной формой сх некоторого фиксированного порога. [c.9]