Дискретный принцип максимума получается почти по такой же схеме, но вместо дифференциальных уравнений в выкладках участвуют их разностные аппроксимации. И вот здесь появляется упомянутое реальное следствие дискретной теории разностное уравнение для сопряженного уравнения является следствием того или иного выбора аппроксимаций для прямого уравнения и для интеграла в тождестве Лагранжа. Разностная аппроксимация уравнения в вариациях также однозначно определяется выбором аппроксимации исходного уравнения, но это не так важно, так как в вычислительных методах обычно это уравнение не интегрируется. Эту аппроксимацию сопряженного уравнения "мы будем называть согласованной с аппроксимациями исходного уравнения и интеграла в том смысле, что для конечно-разностных решений Sz и ф, полученных по согласованным аппроксимациям соответствующих уравнений, алгебраически точно выполняется тождество Лагранжа (тоже в соответствующей аппроксимации). Это и есть то единственное практическое следствие, которое автор смог извлечь из теории дискретного принципа максимума и которого в своих вычислениях никогда не использовал ни в явной, ни в неявной формах. Автор всегда выбирал для исходного и сопряженного уравнений независимые аппроксимации, причем сопряженное обычно интегрировалось более грубо, с большим шагом по времени. Дело в том, что использование согласованной > аппроксимации связано с определенными техническими неудобствами, необходимость преодоления которых не очевидна. Во всяком случае, автору неизвестны трудности численного решения задач оптимального управления, которые можно было бы преодолеть, используя согласованную аппроксимацию. Чтобы и здесь быть более конкретным, можно все же указать на некоторое следствие использования согласованной аппроксимации. Речь идет о получении минимума функционала с большим числом знаков. Используя для вычисления функциональной производной функцию < >, найденную по произвольной аппроксимации сопряженного уравнения, мы, разумеется, находим не точную производную, а лишь приближенную, искаженную влиянием ошибок аппроксимации. Поэтому получить минимум с очень большой точностью не удастся начиная с некоторого этапа минимизации (например, методом градиента в функциональном пространстве) мы будем в этом случав [c.54]

Первые методы приближенного решения задач оптимального управления были методами градиента в функциональном пространстве и применялись к простейшим задачам найти [c.110]

Используется какой-нибудь алгоритм безусловной оптимизации, например, метод градиента, усиленный привлечением идей метода сопряженных градиентов. Точка и используется, как начальная в этом процессе спуска. После этого в новой точке и, g, л делается пересчет множителей Лагранжа [c.462]

Смысл этого подхода состоит в использовании характеристик целевой функции в текущей точке для определения направления движения. Затем в этом направлении происходит перемещение в рамках области возможных решений в новую точку, и процесс повторяется. Иногда для описания этого подхода используется термин "восхождение на холмы". Выбор направления может быть сделан посредством изучения или оценки градиента функции (отсюда термин "метод градиентов"), или другими способами (методы прямого поиска). [c.456]

Более точно градиент может быть вычислен, если известно линейное приближение поверхности отклика, полученное по числу точек, превышающему число переменных. Боксом и Уилсоном предложено определять градиент по линейному приближению поверхности отклика на основе дробного факторного эксперимента. Если градиент рассчитывается заново после каждого шага решения, то это метод градиента. Если же в направлении градиента выполняется несколько шагов до тех пор, пока не перестанем приближаться к оптимуму, то это метод крутого восхождения или наискорейшего спуска, [c.270]

Известны строгие математические методы решения задач оптимизации (например, симплекс-метод и распределительный метод для линейных задач, метод градиента для задач нелинейных, методы Беллмана для задач динамического планирования и т. д.). Но в аудите эти методы в настоящее время не применимы в силу неразработанности формальных или стохастических (вероятностных) зависимостей между варьируемыми факторами, с одной стороны, параметрами оптимизации и ограничивающими функциями — с другой. Поэтому приближение к оптимальности достигается, как это предусмотрено общероссийским стандартом Планирование аудита , эмпирически — вариантностью планирования, выявлением в ходе планирования областей повышенного риска, корректированием принятых решений в ходе проверки. [c.137]

Метод крутого восхождения (Бокса-Уилсона) (10.2.) — процедура нахождения оптимума при планировании экспериментов, основанная на линейной модели и методе градиента. [c.344]

В настоящее время добыча нефти из месторождений, разрабатываемых с искусственным заводнением, превышает 75% от всего объема добычи. Этот метод и в ближайшем будущем останется основным. Однако для залежей, на которых обычное заводнение не может обеспечить достаточно высокой нефтеотдачи, приходится применять другие методы разработки. В первую очередь это методы циклического воздействия переменных потоков, применение высоких давлений и градиентов.давлений, направленные на совершенствование технологии заводнения путем повышения охвата пластов заводнением. [c.10]

Одно из перспективных направлений совершенство- вания внутриконтурного заводнения — повышение давления нагнетания (до 200—400 кгс/см2) с одновременным снижением забойного давления в эксплуатационных -скважинах ниже давления насыщения. Это вызывает увеличение градиента давления, что при прочих равных условиях способствует увеличению текущей добычи нефти. Основное достоинство этого метода заключается в том, что он позволяет вовлечь в разработку малопроницаемые зоны пласта. Наиболее эффективно он приме- [c.10]

Теперь рассмотрим случай оптимизационного исследования. Пусть существует единственный критерий функционирования системы U (st, s2) скажем, среднее за весь период планирования потребление с в расчете на душу населения. Надо найти с помощью имитационных экспериментов оптимальный вариант управлений sx и s2. Это можно сделать с помощью различных градиентных методов поиска экстремума функции U (s1 s2), причем построение градиента функции U (sb s2) основывается на экспериментальном подсчете значений этой функции в нескольких точках (SL s2). В теории планирования эксперимента разработаны методы разумного выбора таких точек. [c.286]

При решении задачи можно выбрать метод экстраполяции оценок переменных для каждого шага поиска — линейная или квадратичная (для задач с нелинейной целевой функцией), метод численного дифференцирования для целевой функции — прямые или центральные разности (для задач с нелинейной целевой функцией), метод поиска — метод Ньютона (требуется много оперативной памяти) или метод сопряженных градиентов (больше итераций). Основным ограничением модели является максимальное число переменных — 200. Несколько оптимизационных моделей на одном листе можно сохранять и загружать по мере необходимости. [c.457]

По использованию производных. Некоторые методы требуют вычисления первой производной целевой функции. В многомерном случае первая производная представляет собой векторную величину, называемую градиентом. [c.186]

Это метод общей оптимизации и поиска, который был применен к решению многих задач. Нередко его применяли в нейронных сетях, ибо он хорошо сокращает помехи и размерность крупных нелинейных задач. Поскольку этот метод не требует информации о градиенте, его можно применять и к разрывным, и к эмпирическим функциям точно так же, как он применяется к аналитическим функциям. [c.189]

Обратите внимание, что если постоянно использовать в торговле тот метод, который в данный момент имеет больший градиент, то с наибольшей вероятностью счет в любой момент времени будет в своей наибольшей части доступного капитала. Так, мы начинаем торговать на базе фиксированного контракта с числом единиц, равным тому, которым бы мы начинали торговлю при дробном / [c.238]

Далее, в тот момент (по времени или по приросту капитала), когда доминирует статичный градиент/, мы переключаемся на торговлю со статичным / Наконец, когда доминирует динамичный градиент, мы переходим на торговлю на основе динамичного/ Обратите внимание, что, постоянно используя тот метод, у которого в данный момент наибольший градиент, вы всегда будете находиться на самой высокой кривой из трех, изображенных на рис. 5.3. [c.238]

Мы видим, что наибольший градиент для двух первых периодов владения дает игра на основе постоянной ставки, а на третий период нам следует переключиться на статичное / На семнадцатом периоде нам нужно переключиться на динамичное / Если бы мы поступили таким образом, то, как это видно на рис. 5.5, за первые двадцать конов преуспели бы в среднем гораздо больше, чем при простом использовании метода динамичного / [c.241]

Обратите внимание, что в каждом периоде при описанном подходе ставка в игре имеет большее ожидаемое значение, чем даже при игре с динамичным дроблением / Далее, начиная с семнадцатого периода, где мы переключились со статичного на динамичный метод, обе линии впредь имеют одинаковый градиент. То есть динамичная линия никогда не сможет догнать линию постоянного доминирования. Таким образом, принцип постоянной торговли с наибольшим градиентом для достижения постоянного доминирования помогает управляющему капиталом максимизировать величину счета в любой момент в будущем, а не только в асимптотическом смысле. [c.241]

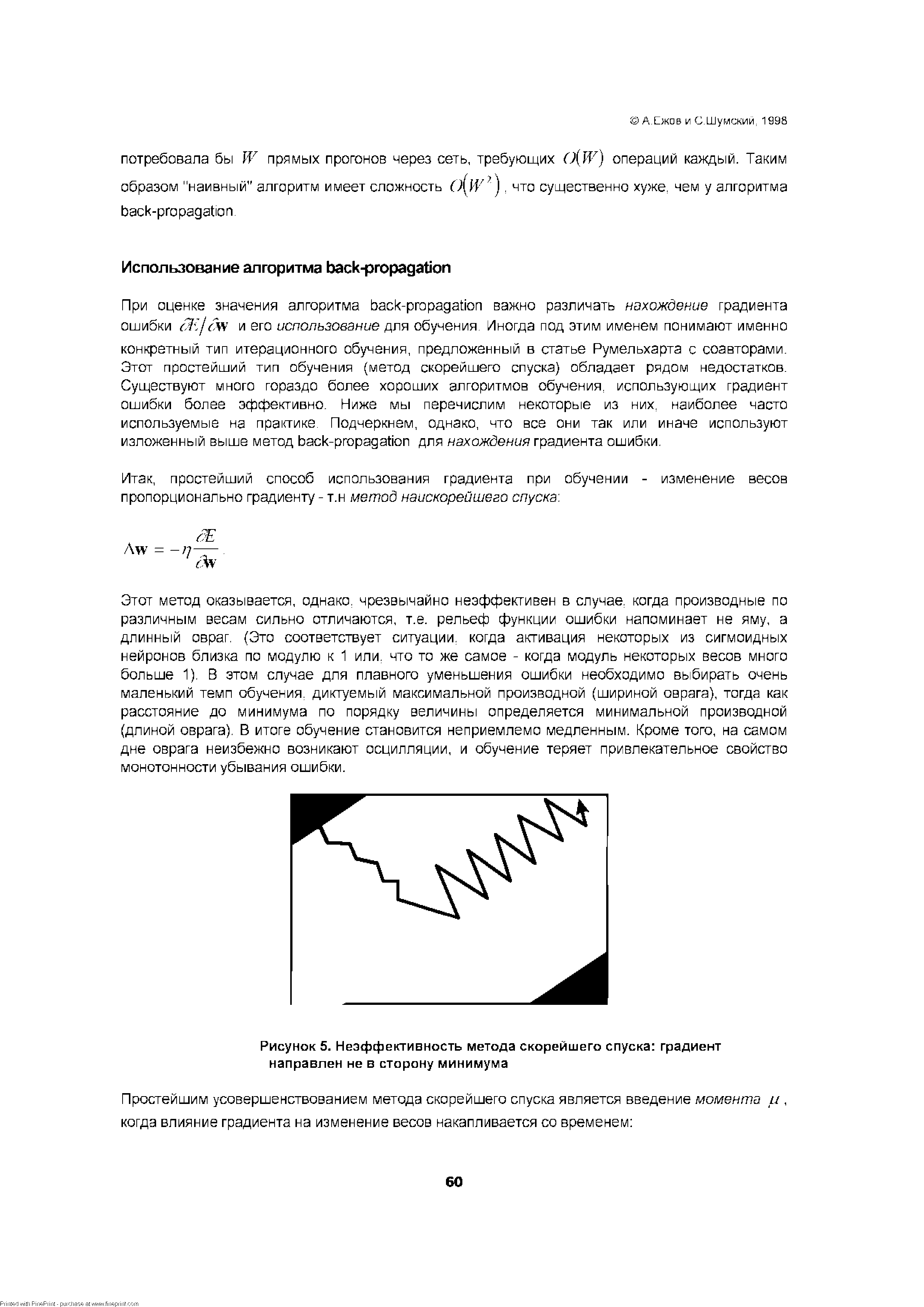

| Рисунок 5. Неэффективность метода скорейшего спуска градиент направлен не в сторону минимума |  |

Альтернативная стратегия - найти требуемые PW2 параметров за W шагов метода первого порядка, затратив на каждом шаге P W операций. Именно такую скорость сходимости ( W итераций) имеют лучшие алгоритмы первого порядка (например, метод сопряженного градиента). В обоих случаях оптимистическая оценка сложности обучения сети (т.к. она [c.62]

Минимизация величины Е осуществляется с помощью градиентных методов. В первом из них берется градиент общей ошибки, и ве-са W пересчитываются каждый раз после обработки всей совокупности обучающих примеров ( эпохи ). Изменение весов происходит в направлении, обратном к направлению наибольшей крутизны для функции стоимости [c.27]

Полищук Л. И. Методы обобщенного градиента в диалоговых процедурах векторной оптимизации//Автоматика и телемеханика. 1981. № 5. [c.163]

Заметим, кроме того, что не все задачи выпуклого программирования приспособлены к использованию ряда известных эффективных методов решения. Применение таких методов выпуклого программирования, как методы возможных направлений, метод секущих плоскостей и других методов, связанных с вычислением градиентов функций, определяющих ограничения задачи, предполагает выпуклость каждой из этих функций в соответствующую сторону (в зависимости от знака неравенства). [c.70]

Дисперсия D(aax) линейной формы аох — выпуклая функция х в гильбертовом пространстве Нп. Градиент D(a0x) в точке х равен 2(айх — а0х)ат0. Здесь а=Ма. В соответствии с процедурой метода возможных направлений итеративный процесс решения задачи (9.20) — (9.22), исходящий из начала координат, приводит к решающему правилу х (а), удовлетворяющему соотношению [c.132]

В 1 исследуется метод обобщенных стохастических градиентов — итеративный метод, позволяющий по реализациям наборов случайных 180 [c.180]

Метод обобщенных стохастических градиентов [c.181]

Метод обобщенных стохастических градиентов, предложенный в работах [106 — 109], не предполагает дифференцируемости целевой функции задачи и не требует задания статистических характеристик случайных параметров условий задачи. Метод стохастических градиентов является общим методом стохастической аппроксимации (см. гл. 15). [c.181]

Метод стохастических градиентов может быть использован также для решения нелинейной двухэтапной стохастической задачи. [c.181]

Применение метода обобщенных стохастических градиентов основано на следующих соображениях. [c.181]

Численные методы анализа многоэтапных стохастических задач в жесткой постановке весьма громоздки, и с увеличением размерности управлений и числа этапов трудоемкость решения задач быстро растет. Методы динамического программирования перестают быть эффективными уже при размерности состояний системы, равной трем. Методы, основанные на схемах блочного программирования, применимы лишь при конечном (относительно небольшом) числе реализаций наборов параметров условий задачи. Метод стохастического градиента неконструктивен при числе этапов, большем двух. Теоретически корректный метод случайного поиска, предложенный в [ПО], связан с большими вычислительными трудностями. [c.202]

В частных случаях, рассмотренных в гл. 8, для вычисления Xi — решения задачи первого этапа — имеются конструктивные приемы. В общем случае, когда задача первого этапа оказывается выпуклой и область K=Ki П Kz ее определения задана явно, можно вычислить xi по методу стохастического градиента [107]. Знание je i=J i позволяет сократить число этапов в исходной задаче на единицу. Параметры условий полученной таким образом задачи зависят от реализации MI. В некоторых задачах специальной структуры параметрические методы исключают необходимость в решении множества задач, определяемых возможными реализациями он. В общем случае требуются весьма громоздкие вычисления. Для некоторого набора реализаций он, выбор которого обусловлен структурой задачи, следует, используя, например, метод стохастических градиентов, вычислить узлы сетки (таблицы). значений x z( i), по которой можно восстановить с требуемой точностью значения составляющих x z(u)i) для произвольной реализации он. Этот процесс может быть продолжен. Однако с увеличением числа этапов трудоемкость вычислений и требования к памяти чрезвычайно быстро растут. При немалых п представляется более перспективным сведение многоэтапной задачи к вычислению апостериорных решающих правил одноэтапных задач. Если восстановление априорных решающих правил исходной задачи по апостериорным решающим правилам одноэтапной задачи связано со значительными вычислительными трудностями, целесообразно после вычисления x i рассматривать второй этап задачи (6.7) — (6.9) (при каждой реализации oi) как одноэтапную-задачу с апостериорными решающими правилами. [c.254]

Применение метода градиента также затрудняется наличием ограничений, накладываемым на зону поиска, так как попав в запретную зону , необходимо делать шаг по градиенту ограниче-здий (зона поиска с учетом ограничений (42—44) представлена на рис. 7). Ввиду этого резко уменьшается скорость движения к цели. [c.45]

Метод градиента в классической аадаче. Пусть х° (t) — некоторое исходное приближение, удовлетворяющее краевым условиям (2). Один шаг спуска состоит"в"следующем строится направление спуска в функциональном""пространстве — функция у (t), удовлетворяющая краевым условиям у (0)=0, у (7Т)=0, и следующее, лучшее приближение ищется в виде [c.218]

Здесь следует отметить несколько разновидностей движения по поверхности отклика. Если бывает затруднительно определить градиент, используют метод Гаусса-Зейделя. По этому методу производится поочередное изменение каждого параметра в направлении оптимума с помощью пробных шагов. Это относительно длинный путь к оптимуму. Сам метод градиента тоже имеет несколько разновидностей. Градиент может вычисляться на основе выполнения одного пробного шага по каждой переменной (для Двух переменных будет использоваться одна центральная точка и две пробных). [c.270]

Наибольшую известность из последовательных методов поиска экстремума получили покоординатный и градиентный методы. Разновидностью градиентного метода является популярный метод наискорейшего подъема. Поиск экстремума по этому поводу производится итеративно. На каждой итерации осуществляется два этапа. На первом этапе (анализе) производится определение составляющих градиента, т. е. частных производных целевой функции 3=f(y, q) по оптимизирующим параметрам у и q. Во время второго этапа делается рабочий шаг, т. е. смещение в направлении градиента [c.45]

В 1999-2000 г.г. разработан и внедряется в производство новый АМК ГОРИЗОНТ-90 , предназначенный для геофизических исследований горизонтальных скважин и боковых стволов методами КС (четыре симметричных градиент-зонда), ПС, ГК, НГК-бО, ННК-20, ННК-40 и инклинометрии. [c.68]

Базовой идеей всех алгоритмов обучения является учет локального градиента в пространстве конфигураций для выбора траектории быстрейшего спуска по функции ошибки. Функция ошибки, однако, может иметь множество локальных минимумов, представляющих суб-оптимальные решения. Поэтому градиентные методы обычно дополняются элементами стохастической оптимизации, чтобы предотвратить застревание конфигурации сети в таких локальных минимумах. Идеальный метод обучения должен найти глобальный оптимум конфигурации сети4. [c.45]

Мы не затронули здесь более изощренных методов обучения, таких как метод сопряженного градиента, а также методов второго порядка, которые используют не только информацию о градиенте функции ошибки, но и информацию о вторых производных. Их разбор вряд ли уместен при первом кратком знакомстве с основами нейрокомпьютинга. [c.62]

Существует два основных подхода к управлению темпом обучения персептрона методом обратного распространения ошибки. При первом этот темп одновременно и равномерно уменьшается для всех нейронов сети в зависимости от одного глобального критерия -достигнутой среднеквадратичной погрешности на выходном слое. При этом сеть быстро учится на начальном этапе обучения и избегает осцилляции ошибки на позднем. Во втором случае оцениваются изменения отдельных межнейронных связей. Если на двух последующих шагах обучения инкременты связей имеют противоположный знак, то разумно уменьшить соответствующий локальный темп - впротивном случае его следует увеличить. Использование нечетких правил может обеспечить более аккуратное управление локальными темпами модификации связей. В частности это может быть достигнуто, если в качестве входных параметров этих правил использовать последовательные значения градиентов ошибки. Таблица соответствующих правил может иметь, например следующий вид [c.208]

При более последовательном подходе для улучшения процесса обучения можно использовать информацию о производных второго порядка от функции невязки. Соответствующие методы оптимизации называются квадратичными. Вся указанная информация собрана в матрице гессиана Н, имеющей размеры Nw х Nw, где Nw — число весов. Эта матрица содержит информацию о том, как изменяется градиент при малых смещениях по различным направлениям в пространстве весов. Прямое вычисление матрицы требует большого времени, поэтому разработаны методы, позволяющие избежать вычисления и хранения матрицы (спуск по сопряженному градиенту, масштабированный метод сопряженных градиентов (см. [197]), RBa kProp (см. [212]), квази-ньютоновский метод, метод Левенбер-га-Маркара). [c.32]

АНТИГРАДИЕНТ [antigradient] — вектор, противоположный градиенту функции и, следовательно, направленный в сторону ее наискорейшего убывания. См. Градиентные методы. [c.23]

ГРАДИЕНТНЫЕ МЕТОДЫ [gradient methods] — методы решения задач математического программирования (вычислительные алгоритмы), основанные на поиске экстремума максимума или минимума) функции путем последовательного перехода к нему с помощью градиента этой функции. [c.66]

Разработан ряд стохастических методов решения поставленной оптимизационной задачи распараллеливания вычислений. В первом методе — стохастическом методе попарной оптимизации подграфов — поиск оптимального решения осуществляется за счет взаимного (стохастического) переноса вершин между различными парами подграфов графа алгоритма. Второй метод — метод Монте-Карло случайного блуждания вершин графа алгоритма по подграфам — основан на отождествлении вершин графа алгоритма с некоторыми частицами, совершающими случайные блуждания по областям-подграфам в потенциальном силовом поле, роль потенциала которого играет минимизируемый функционал. Наиболее вероятное состояние подобной системы частиц соответствует минимуму потенциала —-и, следовательно, является искомым решением. Поиск такого состояния осуществляется методом Монте-Карло с использованием специальной процедуры имитации отжига . Третий метод — стохастический метод наискорейшего спуска — основан на использовании дискретного аналога градиента минимизируемого функционала. Все разработанные методы реализованы программно и являются частью системы программ PARALLAX. Проведено тестирование созданных программ и сравнение их работы на простейших примерах. [c.166]

Итак, известно, как вычислять градиент g((f>) и матрицу Гессе Gf(0) из (2) и (3). Метод Ньютона— Рафсона заключается в следующем. Выбирается на- [c.467]

Как уже отмечалось, метод обобщенных стохастических градиентов не требует дифференцируемости целевой функции эквивалентной детерминированной задачи. Здесь мы рассмотрим возможный вариант применения метода возможных направлений к решению двух-этапной задачи линейного стохастического программирования. Использование и обоснование этого метода требует существования и непрерывности градиента целевой функции эквивалентной детерминированной задачи. В 4 гл. 6 указывалось, что для этого достаточно, чтобы вероятностная мера была абсолютно непрерывна относительно меры Лебега. Как и при изложении других методов, будем предполагать возможность вычисления всех математических ожиданий, значения которых используются в излагаемом ниже алгоритме. [c.189]